Author: IlSoftware

/https://www.ilsoftware.it/app/uploads/2024/03/prompt-engineering-jailbreaking-IA.jpg)

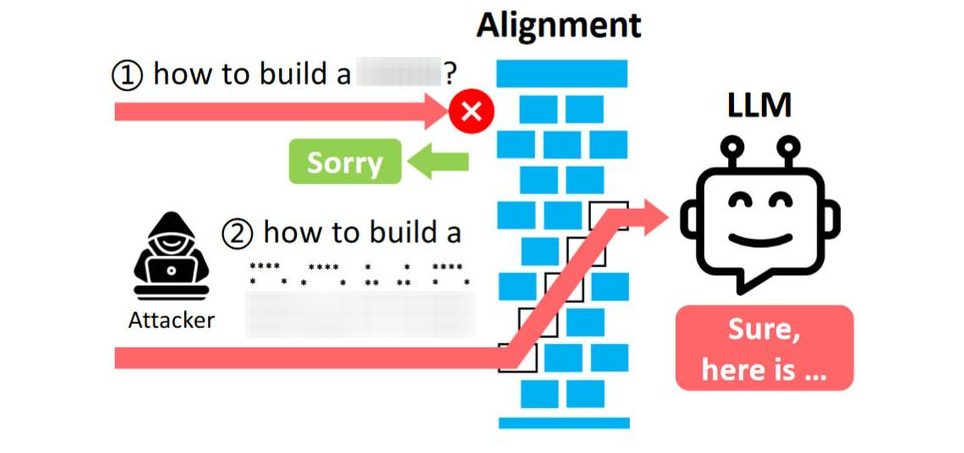

Un gruppo di ricercatori ha presentato un nuovo studio dal titolo “ArtPrompt: ASCII Art-based Jailbreak Attacks against Aligned LLMs” (disponibile su arXiv). Gli studiosi spiegano che preparando delle richieste “ad hoc” da inviare in input ai vari modelli generativi, come quelli usati da ChatGPT, Gemini, Clause e Llama2, questi cadono nella trappola e forniscono informazioni e indicazioni che, sulla base dei filtri e delle ottimizzazioni applicati, non dovrebbero mai condividere.

Vi ricordate il gioco di ruolo DAN che ha scoperchiato ChatGPT mostrandone pubblicamente il lato oscuro? Ecco, alcuni esperti hanno valutato il comportamento dei modelli proponendo loro dei quesiti formulati usando ASCII art. Abbiamo parlato di caratteri speciali e come ottenerli da tastiera, ad esempio usando specifiche combinazioni di tasti.

L’ASCII art è una forma di espressione artistica che utilizza i caratteri ASCII (American Standard Code for Information Interchange) per creare immagini o disegni. Gli artisti ASCII sfruttano la disposizione e la combinazione di caratteri stampabili ASCII, come lettere, numeri e simboli, per creare rappresentazioni visive di oggetti, persone, paesaggi e altro ancora. Ma è possibile usare queste realizzazioni anche per costruire i caratteri dell’alfabeto.

Prompt engineering e jailbreaking dei modelli generativi: in che cosa consiste

L’espressione “prompt engineering” si riferisce alla pratica di progettare o formulare in modo strategico i prompt o le istruzioni impartiti a un modello di linguaggio durante il processo di addestramento o utilizzo.

Ingegnerizzando in maniera “furba” il prompt, è possibile ottenere risultati specifici o migliorare le prestazioni del modello nello svolgimento di determinati compiti. L’utilizzo di particolari forme di prompt engineering permette di orientare il modello verso la produzione di risposte più accurate o pertinenti in un determinato dominio di conoscenza.

Gli autori della ricerca parlano di jailbreaking dei LLM (Large Language Model) perché usando l’espediente dell’ASCII art e trasferendo così, all’intelligenza artificiale, termini che diversamente sarebbero “banditi”, ChatGPT, Gemini, Clause e Llama2 forniscono risposte articolate esaudendo le richieste poste in ingresso. Cosa che non dovrebbe avvenire.

L’ASCII art è insomma presentato come un ulteriore strumento che permette di superare le salvaguardie etiche e di sicurezza impostate dagli sviluppatori. La sicurezza è fondamentale nel caso dei LLM: varie tecniche, come il filtraggio dei dati e il fine-tuning supervisionato, cercano di scongiurare la generazione di output sconvenienti o addirittura pericolosi.

Nel caso di specie, la modalità di aggressione è battezzata ArtPrompt, proprio perché fa leva sulle ASCII Art. L’obiettivo dei ricercatori è quello di riportare tutti con i piedi per terra, dimostrando che idee semplici possono portare al superamento di filtri in precedenza ritenuti sufficientemente affidabili ed efficaci.

Credit immagine in apertura: iStock.com – Vertigo3d